Metody propabilystyczne

W zagadnieniach technicznych niemal zawsze mamy do czynienia z zagadnieniami stochastycznymi i tylko w wielu przypadkach - ze względu na małe rozrzuty - stosuje się podejście deterministyczne. W takich zagadnieniach jak wytrzymałość materiałów i urządzeń (wytrzymałość mechaniczna, elektryczna, cieplna itd.), narażenia (np. atmosferyczne, środowiskowe, przepięcia, przetężenia), analiza błędów pomiarowych, projektowanie, trwałość i niezawodność czy kontrola jakości produkcji, bez stosowania metod probabilistycznych obejść się nie może.

Statystyczne metody badań polegają na wyciąganiu wniosków o dużych zbiorach zmiennej losowej na podstawie badania podzbiorów tej zmiennej losowej. Zbiór, o którego właściwościach wnioskuje się na podstawie badania jego części, jest nazywany populacją generalną. Podzbiór zaś, stanowiący część populacji generalnej poddanej badaniu statystycznemu, na podstawie którego wnioskuje się o populacji generalnej nazywa się próbą lub próbką losową. Statystyczne metody badania, zwane też metodami reprezentacyjnymi, są stosowane wówczas gdy:

populacja generalna jest bardzo liczna, tak iż zbadanie wszystkich elementów kosztowałoby za dużo lub trwałoby za długo;

cała populacja generalna nie jest dostępna;

trzeba szybko otrzymać wyniki badań;

badanie wyrobów powoduje ich niszczenie.

Próbka losowa pobierana w ten sposób, że wszystkie elementy populacji generalnej mają jednakowe szansę trafienia do próbki nosi nazwę próbki losowej prostej. W większości przypadków będziemy mieli do czynienia z taką próbką. Liczbę sztuk w danym zbiorze nazywamy licznością N tego zbioru, a liczbę sztuk w próbce losowej nazywamy licznością próbki n. Badanie próbki reprezentacyjnej dla danej populacji generalnej nazywamy badaniem statystycznym. Zakłada się przy tym, że:

wszystkie sztuki są badane w taki sam sposób;

istnieje niezamierzony rozrzut wartości badanej cechy dla poszczególnych sztuk w badanym zbiorze.

Całokształt badania statystycznego ustalać należy w dokumencie nazywanym programem badań, który powinien zawierać:

określenie badanego zbioru;

przepis badania określający: liczność próbki losowej; sposób pobrania próbki losowej; jakie cechy mają być badane; w jaki sposób mają być wykonane badania;

przepis analizy wyników badań określający: parametry charakteryzujące rozważany zbiór ze względu na badane cechy; sposób wnioskowania o wartościach tych parametrów.

Wynik badania próbki losowej jest losowy, zależy bowiem od przypadku, które sztuki z populacji generalnej wylosowano do próbki losowej. Zatem wynik badania może - wskutek swej losowości - różnić się od wyniku ewentualnego badania populacji generalnej. Rzutuje to na metody analizy wyników badań statystycznych i nakazuje ostrożność przy formułowaniu wniosków.

Dla uzyskania, wspomnianej już, próbki losowej prostej należy stosować tzw. losowanie ze zwracaniem. Losowanie takie polega na tym, że po zbadaniu wylosowanej sztuki zwracamy ją do zbioru i dopiero losujemy następną sztukę. W ten sposób przed wylosowaniem poszczególnych sztuk skład badanego zbioru jest taki sam. Warunek ten jest łatwy do spełnienia przy pomiarach takich zmiennych losowych jak np. napięcie (przebicia, przeskoku, przepięcie) czy prąd (wyładowania atmosferycznego, zwarcia, rażenia) bo każdy kolejny pomiar dotyczy pełnego zbioru zmiennej losowej. Gorzej jest w przypadku np. badań niszczących (np. trwałość żarówek, liczba zadziałań łącznika do uszkodzenia). Jednakże jeśli liczność próbki n jest znacznie mniejsza od liczności populacji generalnej N to przy losowaniu poszczególnych sztuk do próbki losowej zmiany składu zbioru N są małe. Dlatego przy n < 0.01 N można zrezygnować z kłopotliwego losowania ze zwracaniem i stosować losowanie bez zwracania uważając, że nadal uzyskuje się próbkę losową prostą.

Jeśli mamy do czynienia z badaniem wyrobów i możliwe jest ponumerowanie poszczególnych sztuk w badanym zbiorze wyrobów, to w celu lepszego zabezpieczenia losowości próbki wskazane jest korzystanie z tablic liczb losowych [5]. Postępowanie polega wówczas na tym, że poszczególnym sztukom w zbiorze przyporządkowuje się kolejne numery 0, 1, 2, ..... , N-1, a następnie z tablic liczb losowych odczytuje się, rozpoczynając od punktu wybranego na chybił-trafił, n kolejnych liczb losowych stanowiących numery tych sztuk (egzemplarzy), które mają być pobrane do próbki losowej. Cyfry losowe należy czytać wierszami od dowolnie wybranego miejsca tablicy. Można je odczytywać łącząc w liczby jednocyfrowe, dwucyfrowe, trzycyfrowe itd. Należy uwzględniać tylko te numery, które istnieją w rozpatrywanym zbiorze, pomijając numery większe od N-1. Sztukę wylosowaną więcej niż jeden raz bada się tylko jeden raz, a uzyskany wynik uwzględnia się tyle razy ile razy trafiła ta sztuka do próbki losowej. Szansę wielokrotnego trafienia tej samej sztuki do próbki są tym mniejsze im mniejszy jest iloraz n/N.

Należy zwrócić uwagę, że badanie próbki losowej prostej o liczności n jest n-krotnym powtórzeniem tego samego doświadczenia, polegającego na badaniu jednej sztuki wylosowanej z danego zbioru. Wynika z tego, że dowolną serię n jednakowych niezależnych doświadczeń można uważać za próbkę losową prostą, reprezentującą hipotetyczny zbiór takich doświadczeń o nieskończonej liczności i stosować te same metody analizy wyników badań co w przypadku próbki losowej prostej pobranej z określonego, istniejącego zbioru wyrobów. Umożliwia to wnioskowanie o produkcji wyrobów jeszcze w fazie ich opracowywania w laboratorium. Przykładowo wykonaną w laboratorium serię prototypową wyrobów przeznaczonych do produkcji masowej można rozważać jako próbkę losową prostą reprezentującą hipotetyczny zbiór tych wyrobów, wykonanych w taki sam sposób jak badana seria prototypowa. Umożliwia to analizę i odpowiednią korektę projektu w zakresie konstrukcji i technologii jeszcze przed uruchomieniem produkcji.

2. Odwzorowanie zbioru wyrobów na zbiorze liczb

Rozróżniamy dwa rodzaje cech wyrobów technicznych: mierzalną i niemierzalną. Cechą mierzalną nazywa się taką cechę, którą można zmierzyć odpowiednim przyrządem pomiarowym i każdemu badanemu obiektowi przyporządkować liczbę rzeczywistą, uzyskaną z przeprowadzonego pomiaru, nazywaną wartością tej cechy. Dla każdej cechy mierzalnej istnieje zbiór możliwych jej wartości. Zbiór ten może być przeliczalny, np. liczba poprawnych zadziałań przekaźnika i mówimy wówczas, że cecha X jest skokowa lub może to być określony przedział liczb rzeczywistych np. [0, ∞) i mówimy wówczas, że cecha X jest ciągła (np. napięcie przebicia).

Cechą niemierzalną albo opisową nazywa się taką cechę, której nie można zmierzyć np. zwarcie, zadziałanie czy niezadziałanie przekaźnika przy danym sygnale. Można tylko stwierdzić czy dane zjawisko zachodzi czy nie zachodzi i wynik uznać za pozytywny lub negatywny (sztuki dobre lub złe). Każdemu wynikowi “sztuka dobra” można przyporządkować umowną wartość liczbową x1 np. x1 = 1, a wynikowi “sztuka niedobra” x2 np. x2 = 0. Otrzymuje się wówczas dwuelementowy zbiór możliwych wyników { x1, x2}. Przy x1 = 1 i x2 = 0 mamy zbiór {1, 0} zwany zbiorem zero-jedynkowym.

1.3. Opis statystyczny przy klasyfikacji jednowymiarowej

Przy wykonywaniu i analizie badań statystycznych konieczne jest zachowanie przejrzystości i porządku przy opisie badań i wyników. Zaleca się tu następujący schemat opisu:

1) Jednoznaczne scharakteryzowanie badanego obiektu czy zjawiska.

2) Podanie badanej cechy czy cech z określeniem jednostek i dziedziny.

3) Opis sposobu badania.

Sposób badania ma często istotny wpływ na uzyskiwane wyniki. Stąd sposób badania musi być sprecyzowany przed przystąpieniem do badań i z uwzględnieniem założonego celu badań. Przykładowo wynik badania wytrzymałości zależy od sposobu zmian narażeń a także od warunków badań.

4) Określenie liczności badanej próbki losowej. Wybór liczności próbki losowej zależy od celu badań. Przykładowo dla określenia parametrów znanego rozkładu statystycznego potrzebna jest znacznie mniejsza liczność próbki niż dla określenia typu nieznanego rozkładu.

5) Zestawienie zaobserwowanych wartości zmiennej losowej (przykład 1.1. - wiersz (5)).

6) Utworzenie szeregu uporządkowanego badanej zmiennej losowej (przykład 1.1. - wiersz (6)).

Szereg uporządkowany jest to zbiór wartości zmiennej losowej posiadający określoną kolejność w czasie lub przestrzeni. Najczęściej jest to szereg polegający na uporządkowaniu zmiennej losowej od wartości najmniejszej do największej.

7) Utworzenie szeregu rozdzielczego, w którym szereg uporządkowany redukuje się do tych wartości, które nie powtarzają się, przypisując każdej z nich liczbę obserwacji (przykład 1.1. - wiersz (7)).

8) Utworzenie szeregu kumulacyjnego, w którym każdej wartości szeregu uporządkowanego przyporządkowuje się sumy częstości odpowiadające wszystkim wartościom zmiennej losowej nie większym od danej wartości (przykład 1.1. - wiersz (8)).

9) Oszacowanie prawdopodobieństwa z próby (przykład 1.1. - wiersz (9)).

Oszacowanie prawdopodobieństwa z próby powinno spełniać następujące postulaty:

obejmować wszystkie zaobserwowane wyniki;

punkty powinny leżeć między zaobserwowanymi częstościami:

wynik winien być niezależny od rodzaju rozkładu statystycznego;

zaobserwowane wyniki winny być względnie równomiernie rozłożone w skali częstości;

oszacowanie ma mieć prostą postać i intuicyjny sens.

W literaturze spotyka się następujące propozycje dla oszacowania prawdopodobieństwa z próby:

- średnia częstość realizacji zmiennej losowej;

c)

- minimalizuje błąd kwadratowy dla parametru kształtu rozkładu Weibulla;

d)

- mediana wartości rangowych

Wszystkie z pięciu wymienionych na wstępie warunków spełnia jedynie wzór (b). Wzór (a) daje wyniki na skraju przedziału z warunku drugiego i dla ostatniej realizacji z szeregu kumulacyjnego daje wartość 1 (100 %) czyli nieużyteczną w analizie statystycznej dla każdego rozkładu o dziedzinie nieograniczonej od góry - a taką cechę ma większość rozkładów. Zależności (c) i (d) są czasami zalecane w przypadku analiz dokonywanych za pomocą rozkładu Weibulla i dla tego rozkładu zostały sprawdzone. Nie spełniają więc postulatu trzeciego, który zakłada niezależność oszacowania prawdopodobieństwa od postaci rozkładu. Wzór (b) daje ponadto wyższe wartości prawdopodobieństw dla małych wartości zmiennej losowej (rys. 1.1). W zastosowaniach technicznych, szczególnie związanych z zagadnieniami wytrzymałościowymi jest to zaleta. Uzyskuje się bowiem bardziej ostrożne oszacowania dolnego progu wytrzymałości. Z powyższych rozważań wynika, że zalecane oszacowanie prawdopodobieństwa z próby ma postać daną wzorem (b).

Przykład1

1) Żarówki zwykłego szeregu o parametrach 220 V, 75 W

2) Trwałość żarówek w godzinach pracy do uszkodzenia.

3) Równoległe badanie wszystkich elementów próbki losowej aż do zniszczenia ostatniej żarówki.

4) n = 10

5) 2000, 1900, 2100, 1950, 1800, 2200, 2500, 2000, 1900, 2000 [h]

6) xi = 1800, 1900, 1900, 1950, 2000, 2000, 2000, 2100, 2200, 2500 [h]

7) xi = 1800, 1900, 1950, 2000, 2100, 2200, 2500 [h]

ni = 1 2 1 3 1 1 1

8) xi = 1800, 1900, 1950, 2000, 2100, 2200, 2500 [h]

ni = 1 2 1 3 1 1 1

Σ ni = 1 3 4 7 8 9 10

9) xi = 1800, 1900, 1950, 2000, 2100, 2200, 2500 [h]

ni = 1 2 1 3 1 1 1

Σ ni = 1 3 4 7 8 9 10

pi(a) = 0.1 0.3 0.4 0.7 0.8 0.9 1.0

pi(b) = 0.091,0.273,0.364,0.636,0.727,0.818,0.909

pi(c) = 0.05, 0.25, 0.35, 0.65, 0.75, 0.85, 0.95

pi(d) = 0.067,0.26, 0.356, 0.644, 0.74, 0.837,0.933

1.4. Dwie metody analizy statystycznej

W konsekwencji postępowania podanego w punkcie poprzednim uzyskuje się pary liczb (xi, pi) stanowiące punkty rozkładu empirycznego (doświadczalnego) danej cechy X w próbce losowej o liczności n. Rozkład empiryczny należy w dalszej kolejności aproksymować jednym z rozkładów teoretycznych. Takie postępowanie nosi nazwę metody dystrybuanty empirycznej i jak wynika z podanej wyżej procedury, nie wymaga żadnych dodatkowych założeń co do grupowania danych eksperymentalnych.

Inna metoda analiz statystycznych, opierająca się na szeregu rozdzielczym (wiersz 7 z przykładu 1.1), nosi nazwę metody histogramu. Metoda ta daje dość atrakcyjne graficznie wyniki jednakże wymaga dodatkowych założeń co do podziału zakresu zmiennej losowej na klasy i co do liczności realizacji zmiennej losowej w poszczególnych klasach. Zarówno przy wyborze granic klas jak i przy wyborze liczności w klasach występuje dość duża niejednoznaczność kryteriów mogąca dawać spore różnice wyników. Stąd w tej pracy zaleca się stosowanie metody dystrybuanty empirycznej jako bardziej jednoznacznej i bardziej pewnej z inżynierskiego punktu widzenia.

Rys. 1.1 Dystrybuanty empiryczne do przykładu 1.1: x - wzór (a), - wzór (c), ◊ - wzór (d), + - wzór (b). |

Tym niemniej podstawowe zasady metody histogramu są następujące:

należy ustalić obszar zmienności badanej cechy (zmiennej losowej), czyli ustalić przedział ograniczony najmniejszą i największą wartością z próby;

podzielić obszar zmienności na klasy i ustalić reprezentację klasy (środek przedziału klasowego) oraz końce przedziału klasowego; kryteria mogą być różne:

minimum 7 i maksimum 15 klas;

liczba klas w granicach ;

według Huntsbergera ;

według Brooksa i Curruthersa .

policzyć ile elementów próbki należy do danej klasy, czyli określić liczność każdej klasy

Tak definiuje się klasy dla histogramu klasycznego. Możliwe jest również zastosowanie histogramu o założonej liczbie realizacji w klasach. Wówczas ustala się liczbę klas jako równą i oblicza się liczbę realizacji w klasie a następnie uzyskany wynik trzeba zaokrąglić. Mając ustaloną liczbę m i liczbę k określa się granice klas.

Jak widać przy metodzie histogramu istnieje trudność jednoznacznego sprecyzowania jego parametrów.

CZĘŚĆ II

Elementy Niezawodności i Statystycznej Kontroli Jakości

HISTORIA

Jakość jako kategoria filozoficzna

Pojęcie jakości jako kategorii filozoficznej zostało wprowadzone przez Platona (427-346 p.n.e.), który zaprzeczył poglądom Demokryta (ur. około 460 p.n.e.), który z kolei głosił, że istnieje tylko ilościowy, deterministyczny opis rzeczywistości. Platon, a za nim Arystoteles twierdzili, że obiekt rzeczywisty ma nieskończenie wiele cech.

Opis ilościowy polega na podporządkowaniu cechom obiektu wyników pomiarów. Obiekty o identycznych charakterystykach ilościowych mogą się różnić w istotny sposób. W celu rozróżnienia Platon wprowadził pojęcie jakości jako kategorii charakteryzującej obiekt w sposób uwzględniający również to, czego nie można opisać ilościowo.

W wiekach od XVI do XVII przedstawiciele mechanicyzmu (Galileusz, Newton, Laplace) powrócili do bezjakościowego, deterministycznego modelu rzeczywistości.

Niezawodność i ryzyko to również pojęcia ze starożytności, wynikające z praktyk ubezpieczania statków morskich w starożytnym Rzymie.

Niezawodność

Prawdopodobnie pierwszym, który posługiwał się rachunkiem prawdopodobieństwa przy ocenie ryzyka był Jan de Witt (Holender 16251672), który posługiwał się funkcją ryzyka. Pierwszym, który stosował intuicyjne współczynniki bezpieczeństwa był Charles Augustin de Coulomb (Francuz, znany z elektrotechniki, a jednocześnie inżynier wojskowy). Odrębną gałęzią wiedzy niezawodność stała się w końcu lat 50-tych. Na początku lat 70-tych jest to już nauka (system twierdzeń naukowych). Obecnie niezawodność rozumiana jest jako niezawodność techniczna, której jedną z podstawowych dyscyplin jest matematyczna teoria niezawodności. Niezawodność techniczną możemy podzielić na dwie kategorie:

niezawodność projektową R(0) dla czasu t = 0;

niezawodność ruchową R(t).

Współczesne definicje jakości i niezawodności brzmią:

Jakość jest to stopień w jakim obiekt/towar odpowiada wymaganiom użytkownika/klienta.

Niezawodność obiektu jest to właściwość określona przez wartości istotnych wielkości charakteryzujących zdolność obiektu do spełnienia wymagań.

Wielkością charakteryzującą zdolność do spełnienia wymagań może być prawdopodobieństwo spełnienia przez obiekt stawianych mu wymagań. Czyli niezawodność to prawdopodobieństwo sukcesu. Niezawodność obiektu to prawdopodobieństwo, że wartości parametrów określających istotne właściwości obiektu nie przekroczą w ciągu okresu czasu (0, t) dopuszczalnych granic, w określonych warunkach życia obiektu.

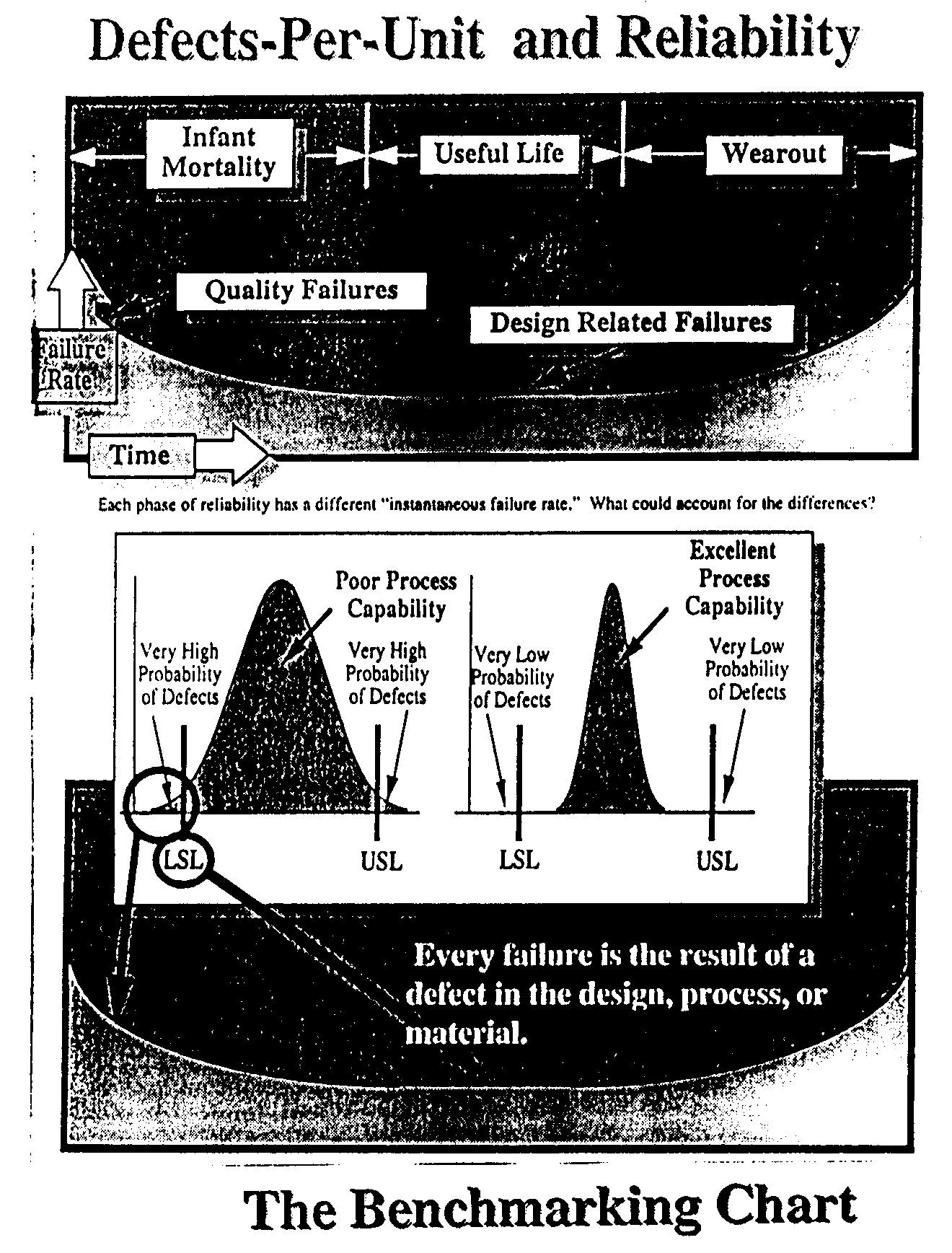

Zależność określającą jaka część obiektów, które przetrwały sprawne w przedziale (0, t) stanie się prawdopodobnie niesprawna w przedziale (t, t + dt) nazywa się funkcją ryzyka albo funkcją intensywności uszkodzeń. Kształt funkcji ryzyka jest istotny pzry ocenie właściwości niezawodnościowych obiektu. Dla t = 0 wartość początkowa R(0) jest jednocześnie niezawodnością projektową. Przykład funkcji ryzyka pokazuje rys. 10.1. Początkowa opadająca część funkcji dotyczy okresu początkowego gdy intensywność uszkodzeń maleje. Powszechnie nazywa się ten fragment funkcji ryzyka śmiertelnością niemowląt. W oparciu o tę część krzywej określa się okresy gwarancyjne. Druga, zwykle niemal płaska część funkcji to okres normalnego użytkowania/pracy obiektu. I wreszcie część trzecia to okres starczy, gdy następuje intensyfikacja zużycia części lub całości obiektu.

Rys. 10.1. Przykładowy kształt funkcji ryzyka

PRAWDOPODOBIEŃSTWO SUKCESU, A STRUKTURA OBIEKTU

Struktura obiektu, który jest sprawny gdy co najmniej k dowolnych spośród n jego elementów jest sprawnych, nazywa się strukturą typu k z n co zapisuje się krótko jako k/n i nazywa się strukturą progową.

Jeśli: k < n to jest to struktura z redundancją (nadmiarowością);

gdzie

- suma wszystkich iloczynów stanowiących kombinacje z R1, ..., Rn po i jak w przykładzie, dla n=4:

k = n to jest to struktura szeregowa;

gdzie: Rei - niezawodność elementu składowego

k = 1 to jest to struktura równoległa.

gdzie: Rei - niezawodność elementu składowego

Układy elektryczne są zwykle strukturami typu szeregowego co oznacza, że uszkodzenie jednego elementu składowego jest jednocześnie uszkodzeniem całego obiektu.

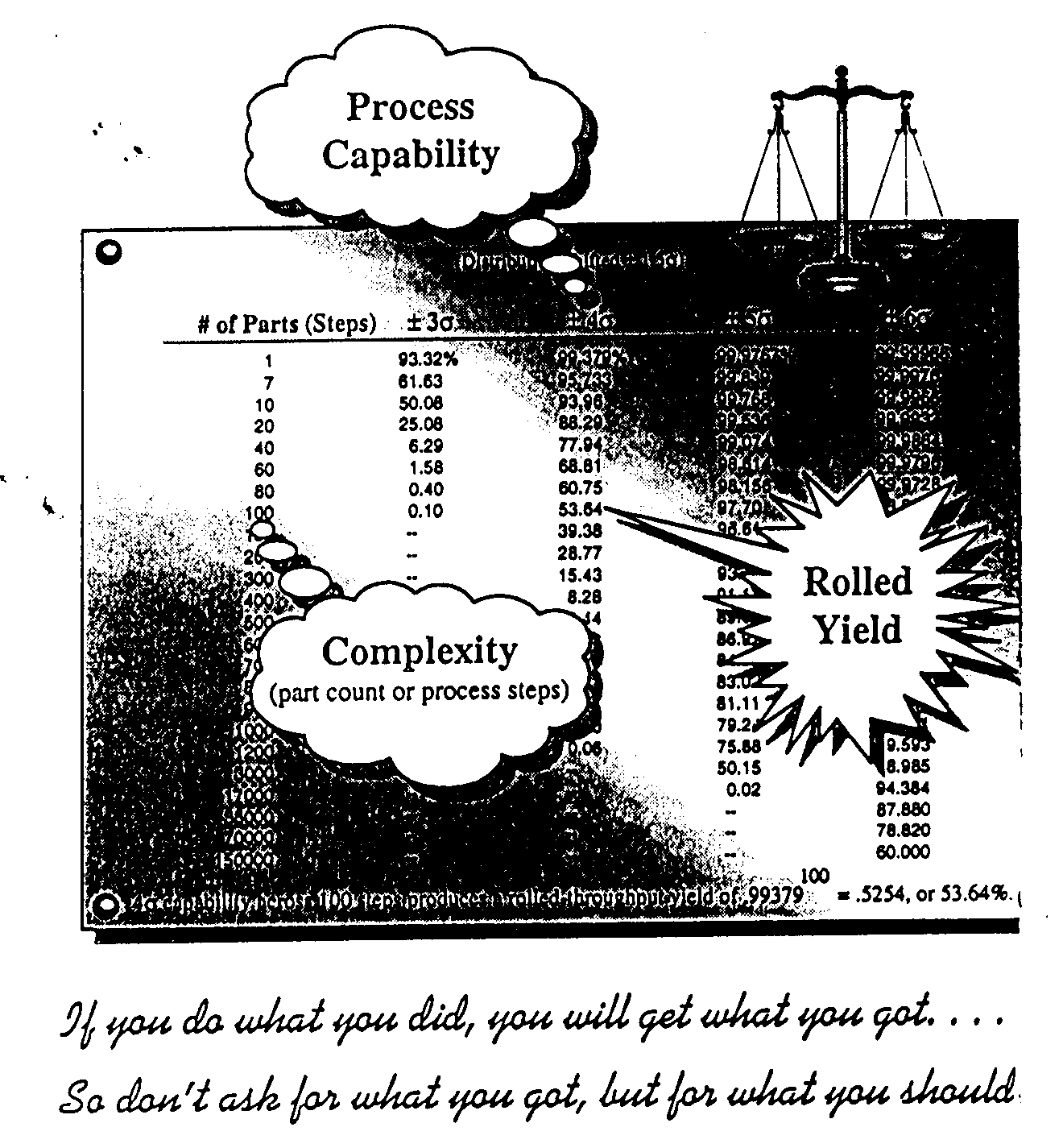

Gdy obiekt składa się z n elementów i każdy ma taką samą niezawodność Re i gdy obiekt jest sprawny wtedy i tylko wtedy gdy sprawne są wszystkie jego elementy, od których zależy sprawność obiektu (struktura szeregowa) to niezawodność obiektu wynosi:

Jest to struktura niezawodnościowa szeregowa n/n, gdzie defekt jednego elementu stanowi o defekcie obiektu. Mówi się wówczas o teorii łańcuch lub teorii słabego ogniwa. Z teorii tej wynikają następujące wnioski praktyczne:

Niezawodność może zaskakująco szybko maleć gdy liczba elementów obiektu rośnie, np. dla Re = 0.99 (obrazuje to również rys. 10.2):

|

Rys. 10.2. Zależność niezawodności obiektu od liczby elementów składowych. Przykład dla Re = 0.99 |

Aby zachować niezmienną niezawodność trzeba ze wzrostem liczby elementów zwiększać niezawodność składników. Przy stałej niezawodności obiektu Rn/n = 0.8, o strukturze szeregowej niezawodność elementów, ze wzrostem ich liczby, musi rosnąć:

n 1 10 100 1000 10000 100000 200000

Rn/n 0.8 0.978 0.9978 0.99978 0.999978 0.999998 0.999999

Z prawa iloczynu wynika, że istnieją sytuacje, w których o defekcie (niepowodzeniu) decydują nie najmniej pewne (najbardziej zawodne) elementy lecz najbardziej pewne (najbardziej niezawodne) jeśli jest ich dużo! Przykładowo w obiekcie składającym się ze 100 elementów, każdy o niezawodności Re = 0.99 i z jednego elementu o niezawodności Re101 = 0.9 wypadkowa niezawodność wynosi:

Jeśli teraz ten najgorszy element poprawić z Re101 = 0.9 na

Re101 = 1.0 to nadal wypadkowa niezawodność wynosi:

czyli element najgorszy decydował tylko o 4% niezawodności.

Jeśli chcemy zwiększyć prawdopodobieństwo sukcesu (niezawodność) to musimy zwracać uwagę przede wszystkim na elementy najliczniejsze. Wystarczy w poprzednim przykładzie zwiększyć niezawodność 100 elementów o 0.5% czyli z 0.99 do 0.995 by niezawodność obiektu wzrosła około dwa razy:

PARAMETRY ROZKŁADU ZMIENNEJ LOSOWEJ

Z rozkładem zmiennej losowej są związane pewne wielkości liczbowe zwane parametrami tego rozkładu. Niektóre z tych parametrów występują bezpośrednio w dystrybuancie danej zmiennej losowej inne natomiast nie występując w dystrybuancie są jednak z nią ściśle związane i charakteryzują rozkład danej zmiennej losowej.

Wartość oczekiwana

Podstawowym parametrem rozkładu zmiennej losowej X jest wartość oczekiwana E(X) nazywana także wartością przeciętną. Wartość oczekiwana określa centrum skupienia wartości danej zmiennej losowej.

Wartość oczekiwaną zmiennej losowej skokowej X o funkcji prawdopodobieństwa p(xi) wyznacza się ze wzoru:

,gdzie Σ oznacza sumowanie po wszystkich możliwych realizacjach danej zmiennej losowej skokowej.

Wartość oczekiwana zmiennej losowej ciągłej X o gęstości f(x) może byc wyznaczona z zależności:

Wartość oczekiwana E(X) jest wyznaczalna tylko wtedy gdy suma lub całka spełniają warunek absolutnej zbieżności, czyli gdy

są wartościami skończonymi. Jeżeli warunek ten nie jest spełniony to mówimy, że dana zmienna losowa X nie ma wartości oczekiwanej.

Wartość oczekiwaną jednoznacznej funkcji ϕ(x) zmiennej losowej X wyznacza się dla zmiennej skokowej z:

i dla zmiennej ciągłej z:

gdzie f(x) jest gęstością zmiennej losowej ciągłej X.

Właściwości wartości oczekiwanej są następujące:

Wartość oczekiwana wartości stałej jest równa tej stałej.

Czynnik stały można wyłączyć przed znak wartości oczekiwanej.

Wartość oczekiwana sumy skończonej liczby zmiennych losowych jest równa sumie wartości oczekiwanych tych zmiennych losowych.

Wartość oczekiwana iloczynu wzajemnych niezależnych zmiennych losowych jest równa iloczynowi wartości oczekiwanych tych zmiennych losowych.

Czyli, że jeśli a0, a1, ..., an są wartościami stałymi to zachodzi równość:

i stąd

a jeżeli zmienne losowe X1, X2, ... , Xn są wzajemnie niezależne, to:

Momenty zmiennej losowej

Wartość oczekiwaną funkcji Xk, gdzie k jest liczbą naturalną, nazywa się k-tym momentem zwykłym lub wprost k-tym momentem zmiennej losowej X i oznacza przez mk. Wartość oczekiwaną funkcji (X - m1)k = [X - E(X)]k nazywa się k-tym momentem centralnym zmiennej losowej X i oznacza przez k.

Dla zmiennej losowej skokowej X o funkcji prawdopodobieństwa p(xi) mamy:

Dla zmiennej losowej ciągłej X o gęstości f(x) mamy:

Dla każdej zmiennej losowej zachodzi m0 = 1 oraz 1 = 0, a momenty centralne rzędu k>1 są związane z momentami zwykłymi zależnością:

Gdzie

jest liczbą kombinacji z k elementów po j. Przy tym zachodzą dodatkowe związki:

Wartości dla n ≤ 20 oraz k ≤ 10 podaje tablica 3.1.

Wariancja

Drugi moment centralny

nazywa się wariancją zmiennej losowej X i oznacza przez V(X). Wariancja V(X) jest zawsze liczbą nieujemną. Wariancja V(X) = 0 wtedy i tylko wtedy, gdy zmienna losowa X ma tylko jedną możliwą realizację co oznacza, że mamy do czynienia z wartością stałą. Dodatni pierwiastek z wariancji

nazywa się odchyleniem średnim zmiennej losowej X i stanowi miarę rozrzutu wartości tej zmiennej wokół jej wartości oczekiwanej.

Ogólnie właściwości wariancji można zestawić w następujących punktach:

wariancja wartości stałej jest równa 0;

czynnik stały można wyłączyć przed znak wariancji, podnosząc go przy tym do kwadratu;

wariancja sumy skończonej liczby wzajemnie niezależnych zmiennych losowych jest równa sumie wariancji tych zmiennych losowych.

Można to zobrazować następującymi zależnościami:

Dla każdej stałej c zachodzi równość:

Zatem wartość E[(X - c)2] osiąga minimum gdy c = E(X) i jest wówczas równa wariancji V(X) danej zmiennej losowej X.

Z wartością oczekiwaną E(X) i odchyleniem średnim σx wiąże się nierówność Czebyszewa:

Przykładowo dla c = 3 uzyskuje się dla dowolnego rozkładu:

Dla wielu szeroko stosowanych rozkładów (np. rozkład normalny) prawdopodobieństwo tego, że wartość zmiennej losowej będzie się różniła od wartości oczekiwanej więcej niż o 3 odchylenia średnie jest znacznie mniejsza od 1/9. Dla tych rozkładów nierówność powyższa nosi nazwę reguły trzech sigma lub prawa trzech sigm.

Współczynnik zmienności

Odchylenie średnie σx i wartość oczekiwana E(X) są wyrażone w tych samych jednostkach co wartość zmiennej losowej. Jeżeli zmienna losowa X przyjmuje tylko wartości dodatnie, to rozrzut jej wartości można określić współczynnikiem zmienności określonym zależnością:

Współczynnik ten jest niezależny od jednostek w jakich są wyrażane wartości zmiennej losowej dając w ten sposób obiektywny pogląd o wielkości rozrzutu tej zmiennej. Współczynnik zmienności najczęściej wyraża się w procentach:

Mediana

Kwantyl rzędu = 0.5 jest nazywany medianą danej zmiennej losowej. Medianę oznacza się jako x0.5 lub * nad symbolem zmiennej. Mediana jest drugim - obok wartości oczekiwanej - parametrem określającym centrum skupienia wartości zmiennej losowej.

Kwantyle

Kwantylem rzędu zmiennej losowej X nazywa się wartość x, dla której są spełnione warunki:

dla określonego z przedziału (0, 1). Dla zmiennej losowej X ciągłej prowadzi to do równości:

Kwantyle zmiennej losowej X i standaryzowanej zmiennej losowej Y są związane zależnością:

Mediana

Kwantyl rzędu = 0.5 jest nazywany medianą danej zmiennej losowej. Medianę oznacza się jako x0.5 lub * nad symbolem zmiennej. Mediana jest drugim - obok wartości oczekiwanej - parametrem określającym centrum skupienia wartości zmiennej losowej.

Moda

Trzecim parametrem charakteryzującym centrum skupienia wartości zmiennej losowej X jest moda lub inaczej wartość modalna oznaczana jako Mo(X) lub za pomocą znaczka ~ nad symbolem zmiennej. Wartością modalną zmiennej losowej ciągłej X jest taka jej wartość x, dla której gęstość f(x) osiąga maksimum, czyli:

Wartością modalną zmiennej losowej skokowej X jest taka jej wartość xi, dla której prawdopodobieństwo P(X=xi) jest większe niż prawdopodobieństwo P(X=xi-1) oraz P(X=xi+1), czyli:

Zmienna losowa może mieć jedną lub więcej wartości modalnych albo może nie mieć jej wcale. Rozkład o jednej wartości modalnej nazywa się jednomodalnym. Istnieją również rozkłady wielomodalne lub bezmodalne.

Rozkład symetryczny i niesymetryczny

Jeżeli istnieje taka wartość m, że dla dowolnej pary realizacji zmiennej losowej X jednakowo odległych od wartości m funkcja gęstości f(x) dla zmiennej losowej ciągłej lub funkcja prawdopodobieństwa p(xi) dla zmiennej losowej skokowej, ma tą samą wartość, to mówimy, że rozkład zmiennej losowej X jest symetryczny względem wartości m nazywanej środkiem symetrii danego rozkładu. Właściwości rozkładów symetrycznych są następujące:

wartość oczekiwana E(X) i mediana x0.5 są sobie równe i równe środkowi symetrii m;

jeżeli rozkład jest jednomodalny to wartość mody Mo(X) jest równa wartości oczekiwanej E(X) i medianie x0.5 i jest spełniona nierówność Campa i Meidella:

- jeżeli rozkład jest ciągły to dla każdego z przedziału (0, 1) średnia arytmetyczna z kwantyli x oraz x-1 jest równa wartości oczekiwanej, czyli:

- wszystkie momenty centralne rzędu nieparzystego są równe 0, czyli:

Współczynnik asymetrii

Korzystając z wzoru na standaryzowaną zmienną losową Y i z właściwości tej zmiennej, jako miarę asymetrii lub skośności rozkładu zmiennej losowej X stosuje się współczynnik asymetrii γ określony wzorem:

gdzie 3 jest trzecim momentem centralnym, a σx odchyleniem średnim danej zmiennej losowej X. Warto dodać, że współczynnik asymetrii (skośności) jest trzecim momentem (zwykłym i jednocześnie centralnym) zmiennej standaryzowanej Y. Jeżeli rozkład jest symetryczny to γ = 0. Gdy γ ≠ 0 to rozkład jest asymetryczny. Gdy γ < 0 to mówi się o asymetrii ujemnej, a gdy γ > 0 to mówi się o asymetrii dodatniej. Ilustruje to rys. 3.1.

|

|

|

Rys. 3.1. Trzy typy rozkładów: |

||

Mo(X) < x0.5 < E(X) |

(b) symetryczny γ = 0 Mo(X) = x0.5 = E(X) |

(c) o asymetrii dodatniej γ > 0 Mo(X) > x0.5 > E(X) |

Wektor losowy

Układ dwóch zmiennych losowych X i Y nazywa się wektorem losowym (X, Y). Wektor losowy ma następujące rodzaje momentów:

Momentem rzędu k + l wektora losowego (X, Y), oznaczonym jako mkl nazywamy wartość oczekiwaną funkcji XkYl, czyli:

Momenty rzędu pierwszego są wartościami oczekiwanymi zmiennych losowych X i Y:

Momentem centralnym wektora losowego (X, Y) rzędu k +l, oznaczonym μkl nazywamy wartość oczekiwaną funkcji [X - E(X)]k[Y - E(Y)]k, czyli:

Momenty centralne rzędu pierwszego μ10 oraz μ01 są równe 0.

Momenty centralne rzędu drugiego są trzy:

wariancje zmiennych losowych X i Y:

oraz mieszany drugi moment centralny:

Kowariancja

Zdefiniowany wyżej moment 11 nazywa się kowariancją zmiennych losowych X i Y. Kowariancja cov(X,Y) oznaczana również jako σXY mówi o stopniu liniowej zależności między zmiennymi losowymi X i Y. Właściwości kowariancji są następujące:

może być dodatnia, ujemna lub zerowa;

cov(X,Y) = cov(Y,X)

cov(-X,Y) = cov(X, -Y) = - cov(X,Y)

cov(X,X) = V(X)

Współczynnik korelacji

W praktyce jako miara zależności liniowej między zmiennymi losowymi X i Y jest stosowany współczynnik korelacji

będący kowariancją standaryzowanych zmiennych losowych

Współczynnik korelacji ma następujące właściwości:

ρ = 0 oznacza brak zależności liniowej między zmiennymi (co nie oznacza, że zmienne muszą być niezależne - może wówczas istnieć zależność nieliniowa;

dla ρ > 0 zachodzi korelacja dodatnia co oznacza, że ze wzrostem jednej zmiennej na ogół rośnie i druga;

dla ρ < 0 zachodzi korelacja ujemna co oznacza, że ze wzrostem jednej zmiennej na ogół maleje druga;

warunek ρ2 = 1 jest warunkiem koniecznym i wystarczającym istnienia między zmiennymi losowymi X i Y jednoznacznej zależności funkcyjnej typu Y = a + bX;

wartość ρ2 określa udział wariancji jednej zmiennej losowej w wariancji drugiej zmiennej losowej;

wariancje sumy i różnicy dowolnych zmiennych losowych X i Y są określone wzorem:

lub ogólniej

Jeżeli zmienne losowe X1, X2, ... , Xn są nieskorelowane to dla każdej pary i ≠ j jest cov(Xi, Xj) = 0 i wzór upraszcza się do postaci:

co oznacza, że wariancja sumy nieskorelowanych zmiennych losowych X1, X2, ..., Xn jest równa sumie wariancji tych zmiennych.

NIEKTÓRE ROZKŁADY ZMIENNYCH LOSOWYCH

NIEKTÓRE ROZKŁADY ZMIENNEJ LOSOWEJ SKOKOWEJ

Rozkład dwumianowy (Bernoulliego)

Rozważmy wynik badania jednej sztuki wylosowanej ze zbioru wyrobów, gdy jest stosowana klasyfikacja alternatywna na sztuki dobre i niedobre. Frakcję sztuk niedobrych w zbiorze wyrobów, nazywana wadliwością tego zbioru, oznacza się przez w. Prawdopodobieństwo wylosowania sztuki niedobrej jest równe w, a prawdopodobieństwo wylosowania sztuki dobrej jest równe 1-w. Jeżeli jest spełniona podwójna nierówność 0<w< 1 i sztukom niedobrym przyporządkować wartość x1, a sztukom dobrym wartość x2≠x1 to wynik badania wylosowanej sztuki jest dwupunktową zmienną losową X, przyjmującą wartości x1 i x2 z prawdopodobieństwami:

W praktyce przyjmuje się x1 = 1 oraz x2 = 0 i wówczas wynik badania wylosowanej sztuki jest zero-jedynkową zmienna losową X o rozkładzie określonym prawdopodobieństwami:

Wartość oczekiwana i wariancja zmiennej losowej X o rozkładzie zero-jedynkowym wynoszą odpowiednio:

Zakładając, że z partii wyrobów o wadliwości w pobrano próbkę losową prostą o liczności n sztuk, w wyniku badań poszczególnych sztuk uzyskuje się wzajemnie niezależne zmienne losowe X1, X2, .... , Xn o jednakowym rozkładzie zero-jedynkowym każda. Liczba sztuk niedobrych w próbce jest zmienną losową (statystyką) Z określoną wzorem:

a częstość zdarzenia sztuka niedobra, czyli frakcja sztuk niedobrych w próbce jest zmienną losową (statystyką) H określoną wzorem:

przy czym Xi jest wynikiem badania i-tej sztuki w próbce (0 lub 1). Statystyka Z może przyjmować wartości ze zbioru liczb {0, 1, 2, ... , n} natomiast statystyka H=Z/n może przyjmować wartości ze zbioru liczb

przy czym prawdopodobieństwa zdarzeń Z=k oraz H=k/n są jednakowe i określone wzorem:

gdzie

jest liczbą różnych kombinacji k sztuk niedobrych w próbce o liczności n (tablica 3.1). Rozkład powyższy nosi nazwę rozkładu Bernouliego lub dwumianowego.

Prawdopodobieństwo, że w próbce o liczności n będzie co najwyżej z sztuk niedobrych lub, że częstość zdarzenia sztuka niedobra będzie co najwyżej h=z/n jest określone wzorem:

Do obliczeń wygodnie jest korzystać ze wzoru rekurencyjnego:

Przykład rozkładu P(Z=k) podano na rys. 4.1 a rozkładu P(Z≤k) na rys. 4.2.

|

|

Rys. 4.1. Przykład funkcji prawdopodobień-stwa rozkładu dwumianowego: n = 30, w = 0.05 |

Rys. 4.2. Przykład prawdopodobieństwa P(Z≤k) rozkładu dwumianowego: n = 30, w = 0.05 |

Wartości oczekiwane i wariancje statystyk Z i H mają postać:

a współczynnik asymetrii (skośności) rozkładu dwumianowego ma wartość:

Statystyka H = Z/n będąca frakcją sztuk niedobrych w próbce losowej o liczności n jest stochastycznie zbieżna do wadliwości w reprezentowanego przez tę próbkę zbioru wyrobów. Ogólnie ujmuje to prawo wielkich liczb Bernoulliego, które mówi, że częstość zdarzenia losowego w n jednakowych niezależnych doświadczeniach jest stochastycznie zbieżna do prawdopodobieństwa tego zdarzenia. Frakcja sztuk niedobrych w zbiorze, czyli wadliwość tego zbioru w, jest prawdopodobieństwem zdarzenia polegającego na wylosowaniu sztuki niedobrej, a frakcja sztuk niedobrych w próbce losowej prostej o liczności n, czyli statystyka H=Z/n, jest częstością tego zdarzenia w n niezależnych jednakowych doświadczeniach, polegających na badaniu sztuk wylosowanych z danego zbioru wyrobów.

Współczynnik asymetrii γ rozkładu dwumianowego jest dodatni przy w < 0.5 i ujemny przy w > 0.5. Przy w = 0.5 wynosi γ = 0. Moduł γ jest funkcją malejącą wartości n i rosnącą wartości 0.5 - w. Przy dostatecznie dużym n można aproksymować rozkład dwumianowy rozkładem normalnym (Gaussa). Jest to dopuszczalne dla tym mniejszego n im mniejsza jest wartość 0.5 - w.

Suma k niezależnych statystyk Z1, Z2, .... , Zk o rozkładach dwumianowych z parametrami n1, n2, .... , nk i tym samym parametrem w ma rozkład dwumianowy o parametrach n = n1 + n2 + .... + nk oraz w. Mówi się, że rozkład dwumianowy jest addytywny. Z addytywności rozkładu dwumianowego korzysta się przy analizie wyników badań dwu lub więcej niezależnych próbek losowych z tego samego zbioru wyrobów, rozważając próbkę losową łączną o liczności równej sumie liczności poszczególnych próbek i liczbie sztuk niedobrych równej sumie liczb sztuk niedobrych w poszczególnych próbkach.

Rozkład Poissona

Przy dużej wartości n i małej wadliwości w, praktycznie przy n > 20 oraz w < 0.2 rozkład dwumianowy można aproksymować rozkładem Poissona o funkcji prawdopodobieństwa:

Aproksymacja taka ułatwia obliczenia, można bowiem korzystać z łatwo dostępnych tablic rozkładu Poissona (tab. 4.1). Korzystając z tablic wyznacza się prawdopodobieństwo

Przykład 4.1

Z dużej partii wyrobów o wadliwości w=5% pobrano próbkę losową o liczności n=40 sztuk. Jakie jest prawdopodobieństwo, że w próbce tej będą co najwyżej 3 sztuki niedobre? Jakie jest prawdopodobieństwo, że w próbce będą dokładnie 3 sztuki niedobre?

Odpowiedź na pierwsze pytanie uzyskuje się bezpośrednio z tablicy 4.1

Λ = n w = 40 0.05 = 2

Dla Λ = 2 i k = 3 z tablicy 4.1 odczytuje się:

P(Z ≤ 3; Λ = 2) = 0.857

Prawdopodobieństwo, że w próbce będą co najwyżej 3 sztuki niedobre wynosi 0.857 (85.7%). Odpowiedź na drugie pytanie uzyskamy jeśli od powyższego wyniku odejmiemy prawdopodobieństwo tego, że w próbce będą co najwyżej 2 sztuki niedobre:

P(Z ≤ 2; Λ = 2) = 0.677

stąd

P(Z = 3; Λ = 2) = 0.857 - 0.677 = 0.18

Prawdopodobieństwo zdarzenia, że w próbce będą dokładnie 3 sztuki niedobre wynosi 0.18 (18 %).

Aproksymacja rozkładu dwumianowego nie jest jedynym zastosowaniem rozkładu Poissona. Jeżeli przykładowo, czas pracy urządzenia wynosi t, a prawdopodobieństwo chwilowej, samo usuwalnej niesprawności w jednostce czasu wynosi to liczba niesprawności w przedziale czasu (0, t〉 ma rozkład Poissona o parametrach Λ = t. Przykład rozkładu Poissona podają rysunki 4.3 i 4.4.

|

|

Rys. 4.3. Funkcja prawdopodobieństwa P(Z=k) rozkładu Poissona dla Λ=2 |

Rys. 4.4. Dystrybuanta rozkładu Poissona P(Z≤k) dla Λ=2 |

Podstawowe właściwości rozkładu Poissona są następujące:

- Wartość oczekiwana i wariancja są sobie równe i równe parametrowi Λ, czyli

E(Z) = V(Z) = Λ

- Współczynnik asymetrii jest zawsze dodatni i maleje przy wzroście parametru Λ, dążąc do 0 przy Λ dążącym do nieskończoności.

Przy dostatecznie dużym parametrze Λ rozkład Poissona można aproksymować rozkładem normalnym.

Rozkład Poissona jest addytywny, czyli że suma niezależnych zmiennych losowych Z1, Z2, .... , Zk o rozkładach Poissona z parametrami Λ1, Λ2, .... , Λk ma rozkład Poissona o parametrze Λ = Λ1 + Λ2 + .... + Λk.

Rozkład geometryczny

W praktyce często zamiast badać próbkę losową o ustalonej liczności bada się kolejno wylosowane sztuki, aż trafi się na sztukę niedobrą lub na określoną liczbę sztuk niedobrych. Jest wówczas ustalona liczba sztuk niedobrych w próbce k natomiast liczność próbki jest zmienną losową oznaczoną przez N.

Załóżmy, że wadliwość badanej partii wyrobów jest równa w i badania prowadzi się do stwierdzenia jednej sztuki niedobrej, zapewniając jednakowe prawdopodobieństwo wylosowania dla wszystkich sztuk w danej partii wyrobów. Liczność próbki N jest wówczas zmienną losową przyjmującą wartości naturalne n = 1, 2, .... z prawdopodobieństwami:

gdyż prawdopodobieństwo wylosowania sztuki niedobrej jest równe wadliwości partii w, a prawdopodobieństwo wylosowania n-1 sztuk dobrych jest (1-w)n-1. Rozkład określony powyższym wzorem nazywa się rozkładem geometrycznym o wartości oczekiwanej i wariancji zmiennej losowej N określonych wzorami:

Przykład funkcji prawdopodobieństwa i dystrybuanty pokazano odpowiednio na rys. 4.5 i 4.6.

|

|

Rys. 4.5. Funkcja prawdopodobieństwa roz-kładu geometrycznego dla w=0.05 |

Rys. 4.6 Dystrybuanta rozkładu geometrycz-nego dla w=0.05 |

Rozkład Pascala

Jeżeli badania prowadzi się do stwierdzenia k sztuk niedobrych to liczność próbki jest zmienną losową N o rozkładzie Pascala:

gdzie jest liczbą kombinacji k-1 sztuk niedobrych wśród n-1 sztuk zbadanych przed stwierdzeniem k-tej sztuki niedobrej. Wartość oczekiwana i wariancja zmiennej losowej N o rozkładzie Pascala wynoszą odpowiednio:

Rozkład geometryczny jest szczególnym przypadkiem rozkładu Pascala przy k=1. Rozkład Pascala o parametrach k i w jest sumą k niezależnych zmiennych losowych o jednakowym rozkładzie geometrycznym z parametrem w.

Przykład 4.2.

Ze zbioru wyrobów o bardzo dużej liczności i wadliwości w=10% losowano po jednej sztuce i poddawano badaniom. Jakie jest prawdopodobieństwo, że dla trafienia na sztukę niedobrą trzeba zbadać 5 sztuk? Jakie jest prawdopodobieństwo, że dla trafienia na 2 sztuki niedobre trzeba przebadać 5 sztuk?

Na pierwsze pytanie odpowiedź daje rozkład geometryczny:

P(X=5;w=0.1) = 0.1(1 - 0.1)5-1 = 0.0656

Na drugie pytanie odpowiedź daje rozkład Pascala:

P(X=5;k=2,w=0.1) = 0.12(1-0.1)5-2 = 0.0292

Rozkład Pascala zmiennej losowej N i rozkład dwumianowy zmiennej losowej Z są związane zależnością:

skąd

gdzie N-1 jest liczbą zbadanych sztuk poprzedzających k-tą sztukę niedobrą.

Ze związku między rozkładem dwumianowym, a rozkładem Poissona wynika przybliżony związek między rozkładami Pascala i Poissona:

słuszny dla w<0.2 oraz n>k. Przy małych wartościach w rozkład Pascala można aproksymować rozkładem Erlanga, a rozkład geometryczny rozkładem wykładniczym.

NIEKTÓRE ROZKŁADY ZMIENNEJ LOSOWEJ CIĄGŁEJ

- Słownik [3] zawiera około 30 stron dotyczących rozkładów statystycznych w tym około 20 pozycji związanych z rozkładami typu normalnego. Zatem tutaj odniesiemy się skrótowo do wybranych - pod kątem potrzeb inżynierskich - podstawowych rozkładów, które najogólniej można podzielić na trzy grupy:

- rozkłady typu addytywnego wynikające z centralnego twierdzenia granicznego, które w ogólnej postaci brzmi: “Przy bardzo ogólnych założeniach, w miarę jak liczba zmiennych losowych będących składnikami sumy staje się wielka, rozkład sumy tych zmiennych przybliża się do rozkładu normalnego.” Głównym przedstawicielem rozkładów tego typu jest rozkład normalny (Gaussa), który omówimy tu w jego klasycznej postaci.

- rozkłady typu multiplikatywnego. Jeśli w centralnym twierdzeniu granicznym mówić o iloczynie zmiennych losowych a nie o ich sumie to mamy do czynienia z rozkładami tego typu. Przedstawicielem jest rozkład logarytmo-normalny.

rozkłady wartości ekstremalnych to rozkłady, które zajmują się ekstremalnymi wartościami zmiennej losowej. W tym wykładzie omówione będą dwa przykłady rozkładów asymptotycznych (których jest ogółem sześć): rozkłady Weibulla i Gumbela (dwuwykładniczy).

Rozkład normalny (Gaussa)

Rozkład normalny jest najstarszym, najlepiej zbadanym i bardzo istotnym dla praktyki rozkładem prawdopodobieństwa zmiennej losowej ciągłej X. Wiąże się on z centralnym twierdzeniem granicznym o czym wspomniano wyżej. Istota i ważność tego twierdzenia polega na tym, że daje ono teoretyczne wyjaśnienie bardzo często obserwowanego eksperymentalnie faktu, iż jeśli bada się zmienną losową uzależnioną od dużej liczby czynników losowych, z których żaden nie ma dominującego wpływu to wynik dobrze daje się opisać rozkładem normalnym. Dystrybuanta rozkładu normalnego ma postać:

a funkcja gęstości ma postać:

gdzie i σ to parametry rozkładu: - środek rozrzutu, który dla rozkładu normalnego pokrywa się z wartością oczekiwaną, medianą i modą; σ - odchylenie standardowe - miara rozrzutu zmiennej losowej. Przykłady funkcji gęstości i dystrybuanty rozkładu normalnego pokazano odpowiednio na rys.4.7 i 4.8.

|

|

Rys. 4.7. Gęstość rozkładu Gaussa dla dwóch wartości mediany =30 i 40 oraz dwóch wartościach σ = 5 i 3. |

Rys. 4.8. Dystrybuanta rozkładu Gaussa dla dwóch wartości mediany =30 i 40 oraz dwóch wartości σ = 5 i 3. |

W tablicach statystycznych podaje się standaryzowaną postać rozkładu, którą uzyskuje się przez podstawienie:

Wówczas dystrybuanta ma postać:

gdzie

Rozkład taki ma parametry μ = 0; σ = 1. Całka

nosi nazwę całki Laplace'a. Dla praktycznych obliczeń wystarczające jest przybliżenie:

Dokładność aproksymacji wynosi:

dla

Właściwości rozkładu normalnego są następujące:

Wartość oczekiwana E(X) =

Wariancja V(X) = σ2

Jeżeli zmienna losowa X ma rozkład normalny N(,σ) to dla dowolnych stałych a i b zmienna losowa a + bX ma rozkład normalny N(a+b, bσ)

Jeżeli niezależne zmienne losowe X1, X2, X3, .... , Xn mają rozkłady normalne o wartościach oczekiwanych 1, 2, 3, .... , n i odchyleniach średnich σ1, σ2, σ3, .... , σn to ich suma ma rozkład normalny , a ich średnia arytmetyczna ma rozkład normalny .

- Jeżeli niezależne zmienne losowe X1, X2, X3, .... , Xn mają jednakowe rozkłady normalne N(,σ to ich suma ma rozkład normalny

, a ich średnia arytmetyczna ma rozkład normalny .

Wadą rozkładu normalnego - szczególnie w zastosowaniach inżynierskich dotyczących wytrzymałości (mechanicznej, elektrycznej, cieplnej itd.) jest nieograniczoność dziedziny zmiennej losowej co oznacza np. że dla narażeń równych zero prawdopodobieństwo uszkodzenia jest większe od zera. Jest to nonsens z fizycznego punktu widzenia. Wadę tę obchodzi się czasem stosując regułę trzech sigma lub stosując rozkłady normalne ucięte, o których jest mowa w punkcie następnym.

4.2.2. Rozkład normalny ucięty

Rozkład normalny ucięty jednostronnie w zerze ma gęstość daną wzorem:

gdzie i σ to parametry rozkładu przed ucięciem; ϕ - funkcja Gaussa dana w tablicy 4.1.

Dystrybuanta tego rozkładu jest określona wzorem:

Wartość oczekiwana i wariancja zmiennej losowej X o rozkładzie normalnym uciętym są określone wzorami:

gdzie ϕ0 jest funkcją Millsa podaną w tablicy 4.1.

Dla > 0 jest E(X) > 0 oraz V(X) < σ2, przy czym ze wzrostem wartości wartość oczekiwana E(X) dąży do , a wariancja V(X) dąży do σ2. Dla μ ≥ 3σ jest co umożliwia pominięcie ucięcia rozkładu i rozważanie go jako rozkładu w przybliżeniu normalnego.

Przykład gęstości i dystrybuanty rozkładu normalnego uciętego w zerze podano odpowiednio na rys. 4.9 i 4.10.

|

|

Rys. 4.9. Gęstość rozkładu Gaussa uciętego w zerze. |

Rys. 4.10. Dystrybuanta rozkładu Gaussa uciętego w zerze |

W praktyce spotykamy się również z rozkładami N(,σ obustronnie uciętymi: od dołu w punkcie a i od góry w punkcie b. Przykładowo jeżeli cecha badana ma rozkład normalny N(,σ i sortujemy wyroby, uznając za dobre tylko te sztuki, które mają wartość cechy w ustalonym przedziale wartości dopuszczalnych [a, b], to rozkład tej cechy w zbiorze sztuk uznanych za dobre (po sortowaniu) jest rozkładem normalnym uciętym w punktach a i b. Gęstość takiego rozkładu jest określona wzorem:

Dystrybuanta rozkładu normalnego uciętego dwustronnie ma postać:

Przykłady pokazano odpowiednio na rys. 4.11 oraz 4.12.

|

|

Rys. 4.11. Gęstość rozkładu Gaussa uciętego w zerze (linia przerywana) i uciętego w punktach a=0 i b=10 (linia ciągła). |

Rys. 4.12. Dystrybuanta rozkładu Gaussa uciętego w zerze (linia przerywana) i uciętego w punktach a=0 i b=10 (linia ciągła). |

Rozkład logarytmo-normalny

Jeżeli w centralnym twierdzeniu granicznym zamiast o sumie niezależnych czynników losowych mówić o ich iloczynie to zamiast rozkładu normalnego mamy do czynienia z rozkładem logarytmo-normalnym o gęstości:

gdzie indeksy lnt oznaczają, że parametry są wyrażone w logarytmach naturalnych zmiennej losowej. Dystrybuanta rozkładu logarytmo-normalnego ma postać:

Przykłady funkcji gęstości i dystrybuanty rozkładu logarytmo-normalnego pokazano na odpowiednio rys. 4.13 i 4.14. Wykresy w skali logarytmicznej są identyczne jak dla rozkładu normalnego. Właściwości rozkładu logarytmo-normalnego są następujące:

Wartość oczekiwana E(Z) = E(lnX) = lnt.

Jeżeli X ma rozkład logarytmo-normalny to lnX ma rozkład normalny.

Wariancja V(lnX) = σlnt.

Iloraz X1/X2 niezależnych zmiennych losowych X1 i X2 o rozkładach logarytmo-normalnych z parametrami 1 i σ1 oraz 2 i σ2 ma rozkład logarytmo-normalny o parametrach .

Parametry występujące w wyrażeniach na gęstość i dystrybuantę lnt i σlnt są wyrażone w wartościach logarytmów zmiennej losowe. Dla celów praktycznych interesujące są właściwości statystyczne samej zmiennej losowe a nie jej logarytmu. Parametry rozkładu zmiennej losowej wyrażone w jednostkach danej zmiennej są następujące:

wartość oczekiwana

wariancja

mediana

moda

Rozkład Weibulla

X0 - parametr przesunięcia (próg wytrzymałości F(X0) = 0) wyrażony w jednostkach zmiennej losowej;

Xm - parametr skali (F(Xm )= 1 - e-1 ≈ 0.632) wyrażony w jednostkach zmiennej losowej;

k - bezwymiarowy parametr kształtu.

Rozkład równomierny

Rozkład potęgowy

ROZKŁADY TESTOWE

Rozkład χ2

Wartość oczekiwana i wariancja Wynoszą odpowiednio:

Mediana wynosi:

Moda dla k ≥ 2 wynosi:

Dla k = 1 moda nie istnieje ponieważ gęstość f(x) → ∝ dla x → 0+

Współczynnik asymetrii ma postać:

Przy k ≥ 30 można rozkład χ2 przybliżyć rozkładem normalnym:

Rozkład χ2 jest addytywny, czyli suma n niezależnych zmiennych losowych o rozkładach χ2 o k1, k2, ...., kn stopniach swobody ma rozkład χ2 o k = k1 + k2 + ...+ kn stopniach swobody.

Rozkład t-Studenta

Wartość oczekiwana E(Tk) = 0.

Wariancja dla k>2.

Rozkład Studenta jest jednomodalny i symetryczny względem wartości 0.

Wariancja V(Tk) istnieje tylko dla k > 2 i maleje ze wzrostem liczby stopni swobody k, a więc rozkład jest tym smuklejszy im większe jest k (rys. 5.4).

Przy k → ∝ rozkład Studenta dąży do standaryzowanego rozkładu normalnego N(0, 1).

W praktyce korzysta się głównie z kwantyli tk, statystyki Tk. Należy to czytać jako: kwantyl rozkładu t-Studenta rzędu o k stopniach swobody.

Ze względu na symetrię rozkładu Studenta względem wartości 0 mamy tk, = - tk,1- .

Dla k > 100 na mocy zbieżności rozkładu Studenta do rozkładu normalnego N(0, 1) można korzystać z przybliżenia: tk, ≈ y, gdzie y jest kwantylem rzędu rozkładu normalnego. Pomiędzy kwantylem a wartością krytyczną rozkładu Studenta zachodzi równość taka, że kwantyl rzędu jest równy wartości krytycznej rzędu .

Rozkład Fischera-Snedecora

Wartość oczekiwana wynosi

i istnieje tylko dla k2 > 2;Wariancja wynosi

i istnieje tylko dla k2 > 4;Wartość oczekiwana istnieje tylko dla k2 > 2, a wariancja dla k2 > 4. Ogólnie k-ty moment statystyki F (zwykły i centralny) istnieje tylko dla k2 > 2k;

Wartość oczekiwana jest większa od 1;

Dla każdej pary liczb naturalnych (k1, k2) jest spełniona równość

;W praktyce korzysta się głównie z kwantyli

, co należy czytać jako kwantyl statystyki F, rzędu α o k1 i k2 stopniach swobody;Wstęp

Oszacowanie punktowe

Rozkład normalny

Rozkład Weibulla

Rozkład Gumbela (dwuwykładniczy)

|

|

Rys. 4.13.Gęstości rozkładu logarytmo-normalnego dla jednakowych wartości oczekiwanych i dwóch różnych rozrzutów zmiennej losowej. |

Rys. 4.14. Dystrybuanty rozkładu logarytmo-normalnego dla jednakowych wartości oczekiwanych i dwóch różnych rozrzutów zmiennej losowej. |

lloczyn niezależnych zmiennych losowych X1, X2, X3, .... , Xn o rozkładach logarytmo-normalnych ma rozkład logarytmo-normalny o parametrach:

Rozkład Weibulla jest jednym z wniosków statystycznej teorii wartości ekstremalnych [2]. Jest to jeden z najbardziej elastycznych - jeśli nie najelastyczniejszy - rozkład statystyczny. Oznacza to, że może zastąpić wiele innych popularnych dotąd rozkładów. Szczególną zaletą tego rozkładu jest posiadanie dolnej lub górnej granicy dziedziny zmiennej losowej. Istnienie granicy dolnej jest nieocenioną właściwością przy rozpatrywaniu wszelkich zagadnień wytrzymałościowych czy to mechanicznych czy elektrycznych. Dystrybuanta rozkładu Weibulla w wersji dostosowanej do zagadnień wytrzymałości elektrycznej ma postać:

gdzie:

Przykłady funkcji gęstości i dystrybuanty rozkładu Weibulla dla różnych parametrów kształtu pokazano odpowiednio na rys. 4.15 i 4.16.

|

|

Rys. 4.15. Funkcje gęstości rozkładu Weibulla dla trzech parametrów kształtu k=1(linia przerywana długa), 3.5 (linia przerywana krótka), 6 (linia ciągła). |

Rys. 4.16. Dystrybuanty rozkładu Weibulla dla trzech parametrów kształtu k=1(linia przerywana długa), 3.5 (linia przerywana krótka), 6 (linia ciągła). |

Wprowadzając przekształcenie:

uzyskuje się rozkład zredukowany do postaci:

Dla k = 1 rozkład powyższy, a więc i rozkład Weibulla w postaci pierwotnej, jest funkcją wykładniczą, czyli bardzo ważny - wykorzystywany szeroko w teorii niezawodności - rozkład wykładniczy jest szczególnym przypadkiem rozkładu Weibulla. Jeśli k = 2 oraz X0 = 0 to uzyskuje się funkcję zwaną rozkładem Rayleigha.

Ponieważ dziedzina zmiennej losowej rozkładu Weibulla o postaci danej powyższym wzorem jest ograniczona lewostronnie a nieograniczona prawostronnie to rozkład jest asymetryczny. Jednakże usytuowanie względem siebie miar wartości centralnych: mediany, mody i wartości oczekiwanej (średniej) oraz znak trzeciego momentu (określającego asymetrię) zmieniają się w funkcji parametru kształtu k. W związku z tym istnieją przypadki pseudosymetrii rozkładu gdy „wydaje się”, że jest on symetryczny. W tablicy 4.1 zestawiono parametry charakteryzujące rozkład Weibulla. W tablicy 4.2 zestawiono wartości zredukowanych miar wartości centralnych z tablicy 4.1 dla tych wartości k, dla których dwie lub trzy z nich są sobie równe i gdy zanika trzeci moment centralny (zanika asymetria).

Tabela 4.1

Parametry związane z rozkładem Weibulla

Parametr |

Symbol |

Wzór |

Mediana |

|

|

Moda |

|

|

Zredukowany moment rzędu l |

|

|

Moment rzędu l |

|

|

Pierwszy moment (średnia) |

|

|

Wariancja |

|

|

Standaryzowana różnica od Xm do X0 |

|

|

Standaryzowana różnica od Xm do |

|

|

Trzeci moment centralny |

3 |

|

Współczynnik asymetrii |

γ |

|

Uwaga: jest funkcja Gamma-Eulere; z - liczba rzeczywista.

Tablica 4.2.

Cztery pseudosymetryczne przypadki rozkładu Weibulla

Warunek |

Parametr |

Mediana |

Moda |

Średnia |

Współczynnik skośności |

|

|

k |

1/k |

|

|

|

γ |

= |

3.25889 |

0.30685 |

0.89363 |

0.89363 |

0.89646 |

0.09350 |

= |

3.31125 |

0.30189 |

0.89525 |

0.89719 |

0.89719 |

0.07447 |

= |

3.43938 |

0.29075 |

0.89892 |

0.90494 |

0.89892 |

0.04057 |

γ=0 |

3.60232 |

0.27760 |

0.90326 |

0.91369 |

0.90114 |

0.00000 |

Uwaga: Odpowiednie wartości wyrażone w jednostkach zmiennej losowej uzyskuje się z wzoru:

Jak wynika z tablicy 4.2, gdy dwie z wartości centralnych mają tę samą wartość to trzecia różni się od nich nieznacznie. Podobnie wówczas gdy współczynnik asymetrii jest równy zeru to wszystkie trzy miary wielkości centralnych mają wartości zbliżone. We wszystkich tych przypadkach rozkład „wydaje się” być symetryczny. Ogólnie wrażenie symetrii rozkładu Weibulla jest zachowane jeśli parametr kształtu jest zawarty w przedziale 3.2 < k < 3.7. W przedziale tym rozkład Weibulla jest „podobny” do rozkładu normalnego i z powodzeniem może rozkład normalny zastąpić, eliminując jego wady takie jak nieograniczoność dziedziny zmiennej losowej. W ten sposób zachowując zgodność rozkładu zmiennej losowej z dotychczas obserwowaną jego normalnością można uzyskać zgodność teorii statystycznej z fizyką zjawisk. Na rys.4.17 wykreślono rozkłady Weibulla o parametrach kształtu k = 3.27 i k = 3.445 w normalnej (Gaussowskiej) siatce prawdopodobieństwa. Na takiej siatce dystrybuanta rozkładu normalnego jest linią prostą ( o siatkach funkcyjnych rozkładów statystycznych będzie mowa w następnym rozdziale). Jak widać rozkłady Weibulla niewiele odbiegają od rozkładu normalnego i to jedynie w zakresie prawdopodobieństw poniżej 10%, który to zakres jest stosunkowo trudny do weryfikacji eksperymentalnej. Minimalne różnice między rozkładami Gaussa i Weibulla stanowią że, w oparciu o ograniczoną liczbę obserwacji zmiennej losowej, trudno jest dokonać wyboru rozkładu przy zastosowaniu jedynie statystycznych kryteriów. Wybór powinien w takich przypadkach być dodatkowo wsparty argumentami wynikającymi ze znajomości fizycznych właściwości badanego zjawiska. Przykładowo aby zniszczyć mechanicznie element maszyny potrzebna jest siła większa od zera, lub aby nastąpiło przebicie elektryczne izolacji konieczne jest napięcie większe (co do wartości bezwzględnej) od zera. W obu przypadkach, z fizyki zjawisk wynika, że istnieje progowa, różna od zera, wartość zmiennej losowej (siły czy napięcia). Zatem rozkład Weibulla będzie lepszym narzędziem nawet wówczas gdy do tej pory posługiwano się - z dobrym wynikiem - rozkładem normalnym. Rozkład Weibulla jest bowiem w zgodzie z fizyką zjawisk.

Rys. 4.17. Dystrybuanta rozkładu normalnego (linia prosta) i dystrybuanty rozkładu Weibulla o parametrach kształtu k = 3.27 i k = 3.445 wykreślone w normalnej (Gaussowskiej) siatce prawdopodobieństwa.

Jeżeli przyjąć za kryterium, że dla wartości średniej prawdopodobieństwo ma wynosić 0.5 (50%) to rozkład Weibulla odpowiadający rozkładowi normalnemu ma parametr kształtu k = 3.5. Ten rozkład najczęściej stosuje się jako pokrywający się praktycznie z rozkładem normalnym w zakresie dostępnym do obserwacji eksperymentalnych. Jest to rozkład o średniej bliskiej medianie (tab. 4.2) i o bardzo małym współczynniku asymetrii ϒ ≈ 0.04.

4.2.4. Rozkład dwuwykładniczy (Gumbela)

Rozkład dwuwykładniczy, podobnie jak rozkład Weibulla, jest wynikiem rozważań teorii wartości ekstremalnych. Postać dystrybuanty tego rozkładu jest następująca:

gdzie: Xm - moda wyrażona w jednostkach zmiennej losowej i spełniająca warunek ; - parametr (wyrażony w odwrotnościach zmiennej losowej) będący miarą rozrzutu zmiennej losowej (im mniejsze tym rozrzut większy i odwrotnie).

Przykłady przebiegów funkcji gęstości i dystrybuanty rozkładu dwuwykładniczego pokazano odpowiednio na rys. 4.18 i 4.19.

Wprowadzając przekształcenie y = (x-Xm) uzyskuje się rozkład standaryzowany:

Wzory określające podstawowe parametry rozkładu dwuwykładniczego zestawiono w tablicy 4.3.

|

|

Rys. 4.18. Gęstości rozkładu dwuwykładniczego dla dwóch wartości parametru (linia ciągła) i 0.02 (linia przerywana. |

Rys. 4.19. Dystrybuanty rozkładu dwuwykładniczego dla dwóch wartości parametru (linia ciągła) i 0.02 (linia przerywana. |

Tablica 4.3

Parametry związane z rozkładem dwuwykładniczym

Parametr |

Symbol |

Wzór |

Mediana |

|

|

Moda |

|

Xm |

Średnia |

|

stała Eulera |

Wariancja |

σ2 |

|

Współczynnik asymetrii |

γ |

-1.1396 |

Porównując rozkład dwuwykładniczy z rozkładem normalnym - obydwa mają dziedziny obustronnie nieograniczone - można zauważyć, że dla małych wartości zmiennych losowych rozkład dwuwykładniczy ma mniejsze wartości funkcji gęstości niż rozkład normalny. Gęstość prawdopodobieństwa mody jest jednak większa dla rozkładu dwuwykładniczego niż dla rozkładu normalnego. Rozkład dwuwykładniczy pokrywa się w przybliżeniu z rozkładem logarytmo-normalnym. Między rozkładem Weibulla a rozkładem dwuwykładniczym zachodzi zależność dla dystrybuant:

czyli, że pomiędzy rozkładem Weibulla a rozkładem dwuwykładniczym zachodzi podobny związek jak między rozkładem normalnym a logarytmo-normalnym.

Rozkład równomierny nazywany bywa również rozkładem jednostajnym lub rozkładem prostokątnym. Jest to najprostszy rozkład zmiennej losowej ciągłej X w przedziale (c, d) określony gęstością:

Dystrybuanta tego rozkładu jest dana wzorem:

a jej wartość oczekiwana i wariancja są określone wzorami:

Graficzną postać gęstości i dystrybuanty rozkładu równomiernego pokazano na rys. 4.20.i n4.20.

|

Rys. 4.20. Gęstość (linia ciągła) i dystrybuanta rozkładu równomiernego |

Rozkład równomierny ma następujące właściwości:

Jeżeli zmienna losowa X ma rozkład równomierny w przedziale (0, d) to zmienna losowa ma rozkład wykładniczy o wartości oczekiwanej 1;

Jeżeli zmienna losowa X ma rozkład równomierny w przedziale (c, d) to zmienna losowa ma rozkład równomierny w przedziale (0, 1) określony gęstością i dystrybuantą:

Wartość oczekiwana i wariancja zmiennej losowej Y o rozkładzie równomiernym w przedziale (0,1) są określone wzorami:

Jeżeli zmienne Y1, Y2, ..... , Yn są niezależne i mają jednakowy rozkład równomierny w przedziale (0, 1) to przy wzroście n rozkład ich sumy dąży do rozkładu normalnego , a rozkład ich średniej arytmetycznej dąży do rozkładu normalnego . Zbieżność rozkładu statystyki Y = Y1 + Y2 + ..... + Yn do rozkładu normalnego jest bardzo szybka. Dla n = 2 uzyskuje się rozkład trójkątny, a dla n = 3 uzyskuje się już kształt rozkładu normalnego (rys. 4.21).

Rys. 4.21. Gęstość rozkładu równomiernego w przedziale (0, 1) (linia przerywana)

i gęstość sumy dwóch niezależnych zmiennych o rozkładach równomiernych

w przedziale (0,1) (lina ciągła)

Załóżmy, że zmienna losowa X ma rozkład równomierny w przedziale (0, c) i jest dana wartość stała δ > 0. Wówczas zmienna losowa T określona wzorem:

ma rozkład potęgowy o funkcji gęstości:

i dystrybuancie:

gdzie c>0 to parametr skali, a δ>0 to parametr kształtu rozkładu. Wartość oczekiwana i wariancja tego rozkładu mają odpowiednio postać:

Przykłady gęstości rozkładu potęgowego pokazano na rys. 4.22 a przykłady dystrybuanty tego rozkładu pokazano na rys. 4.23.

|

|

Rys. 4.22. Gęstości rozkładu potęgowego, dla c=1 i różnych parametrów δ, od δ=0.1 dla lewej linii ciągłej poprzez wartości δ=0.5 i 0.6 (linia pozioma), 2, 3, 4 aż do 6 (prawa linia ciągła) |

Rys. 4.23. Dystrybuanty rozkładu potęgowego, dla c=1 i różnych parametrów δ, od δ=0.1 dla górnej linii ciągłej poprzez wartości δ=0.5, 0.6, 2, 3, 4 aż do 6 (dolna linia ciągła) |

Podstawowe właściwości rozkładu potęgowego można zestawić w następujących punktach:

Rozkład potęgowy o parametrze skali c i parametrze kształtu δ = 1 jest rozkładem równomiernym w przedziale (0, c) (patrz rys. 4.22 i 4.23 wykresy dla δ = 1). Jeżeli zmienna losowa T ma rozkład potęgowy o parametrach c i δ to zmienna losowa T/c ma rozkład potęgowy o parametrze skali 1 i parametrze kształtu δ. Rozkład potęgowy o parametrach c i δ jest przypadkiem granicznym uogólnionego rozkładu gamma (pominiętego w tym wykładzie) o parametrach c; p i ν przy ν→∝ i p⋅ν = const = δ.

W przypadku wnioskowania statystycznego szczególną rolę odgrywają tak zwane rozkłady testowe, z których skrótowo zostaną omówione trzy najczęściej wykorzystywane. Są to rozkłady chi-kwadrat (w skrócie χ2), t-Studenta oraz Fischera.

Jeżeli niezależne zmienne losowe Xi mają standaryzowane rozkłady normalne ( = 0, σ = 1) to zmienna losowa:

ma rozkład χ2 z k stopniami swobody o gęstości:

i dystrybuancie:

gdzie: jest funkcją gamma Eulera (z - liczba rzeczywista).

Funkcję gamma Eulera pokazano na rys. 5.1, a gęstość i dystrybuantę rozkładu χ2 odpowiednio na rys. 5.1 i 5.3.

|

|

Rys. 4.1. Przebieg funkcji Γ(z) dla z > 0 |

|

|

|

Rys. 4.2. Gęstości rozkładu χ2 o różnych wartościach liczby stopni swobody k = 1,2,3,4 |

Rys. 4.3. Dystrybuanty rozkładu χ2 o różnych wartościach liczby stopni swobody k = 1,2,3,4 |

Podstawowe właściwości rozkładu χ2 można zestawić w następujących punktach:

czyli dla każdego k jest

> 0 przy czym

→ 0 gdy k → ∝, to znaczy, że rozkład χ2 ma symetrię dodatnią i ze wzrostem liczby stopni swobody symetryzuje się (rys. 5.2).

W praktyce korzysta się gównie z kwantyli statystyki podane w tablicach. Należy te wartości odczytywać jako: kwantyl statystyki rzędu o k stopniach swobody. Czasem dostępne są tablice wartości krytycznych. Wówczas można wykorzystać zależność, iż kwantyl χ2 rzędu 1- jest równy wartości krytycznej rzędu .

Jeśli rozważyć iloraz zmiennej losowej Y o standaryzowanym rozkładzie normalnym N(0, 1) przez pierwiastek z niezależnej od niej statystyki , czyli statystykę:

to statystyka Tk ma rozkład Studenta o gęstości:

gdzie: jest funkcją beta Eulera.

Wykresy gęstości i dystrybuanty rozkładu t-Studenta pokazano odpowiednio na rys. 5.4 i 5.5 dla różnych stopni swobody k.

|

|

Rys. 4.4. Gęstości rozkładu Studenta dla k=1 (linia ciągła) i dla k=10 (linia przerywana) |

Rys. 4.5. Dystrybuanty rozkładu Studenta dla k=1 (linia ciągła) i dla k=10 (linia przerywana) |

Podstawowe właściwości rozkładu Studenta są następujące:

Jeżeli X1 i X2 są niezależnymi zmiennymi losowymi o rozkładzie χ2 odpowiednio z k1 i k2 stopniami swobody to zmienna losowa (statystyka):

ma rozkład F (Fischera - Snedecora) o k1, k2 (parze stopni swobody) stopniach swobody i o gęstości:

Przykłady gęstości tego rozkładu pokazano na rys. 4.6.

|

|

Rys. 4.6. Przykłady gęstości rozkładu F dla trzech par stopni swobody: 2,12 - 8,12 - 50,50 |

Rys. 4.7. Przykłady dystrybuanty rozkładu F dla trzech par stopni swobody: 2,12 - 8,12 - 50,50 |

Rozkład F ma następujące właściwości:

Pomiędzy kwantylem i wartością krytyczną statystyki F zachodzi związek

.

5.ZASADY STATYSTYCZNEJ ANALIZY WYNIKÓW BADAŃ

Jak już wspomniano na początku podręcznika, analizę statystyczną można oprzeć o funkcję gęstości lub o dystrybuantę. W pierwszym przypadku posługiwać się trzeba histogramem wymagającym podziału na klasy i wyboru liczności klas co prowadzi często do niejednoznaczności uzyskiwanych wyników. W procesach inżynierskich bardziej jednoznaczne wyniki daje metoda dystrybuanty empirycznej. W metodzie tej uzyskaną z badań dystrybuantę empiryczną należy aproksymować dystrybuantą jednego z teoretycznych rozkładów.

Można tego dokonać jedną z trzech metod: metodą graficzną, metodą momentów i metodą największej wiarygodności.

Metoda ta polega na zastosowaniu gotowych wzorów służących do oszacowania parametrów określonego rozkładu. Pomijając całą teorię uzyskiwania odpowiednich wzorów matematycznych służących do oszacowania (estymacji) odpowiednich parametrów, należy tylko wspomnieć, że wzory te zwykle uzyskuje się z wykorzystaniem momentów poszczególnych zmiennych losowych o odpowiednich rozkładach statystycznych (stąd nazwa metoda momentów). Poniżej zestawiono wybrane sposoby estymacji punktowej dla wybranych rozkładów statystycznych.

Wartość oczekiwana będąca podstawowym parametrem rozkładu normalnego szacowana jest ze średniej:

gdzie: n - liczność próbki, xi - zaobserwowane realizacje zmiennej losowej.

Odchylenie średnie standardowe wykorzystywane jest jako estymator odchylenia średniego σ:

Te dwa estymatory definiują poszukiwaną dystrybuantę rozkładu normalnego.

Jedna z metod szacowania parametrów rozkładu Weibulla oparta jest o trzeci moment centralny, którego nieobciążonym estymatorem jest:

Wykorzystując oszacowanie M3 oblicza się współczynnik skośności γ z wyrażenia:

Dla znanego γ odczytuje się z tabeli 5.1 parametry k, A, B, D rozkładu Weibulla (zdefiniowane w tabeli 4.1) oraz oblicza się pozostałe parametry rozkładu z zależności:

Tabela 5.1. Dane liczbowe do szacowania estymatorów rozkładu Weibulla wg [7]

k |

A |

B |

D |

γ |

0.5 |

0.223607 |

0.224 |

0.447113 |

6.619 |

1.0 |

0.000000 |

1.000 |

1.000000 |

2.000 |

1.5 |

0.158669 |

1.631 |

1.472827 |

1.072 |

2.0 |

0.245598 |

2.159 |

1.913046 |

0.631 |

2.5 |

0.296936 |

2.634 |

2.336956 |

0.359 |

3.0 |

0.329748 |

3.081 |

2.751448 |

0.168 |

3.5 |

0.352096 |

3.512 |

3.160028 |

0.025 |

4.0 |

0.368084 |

3.933 |

3.564587 |

-0.087 |

4.5 |

0.379976 |

4.346 |

3.966282 |

-0.178 |

5.0 |

0.389102 |

4.755 |

4.365828 |

-0.254 |

5.5 |

0.395287 |

5.160 |

4.763762 |

-0.319 |

6.0 |

0.402069 |

5.563 |

5.160494 |

-0.374 |

6.5 |

0.406805 |

5.963 |

5.556206 |

-0.423 |

7.0 |

0.410749 |

6.362 |

5.951200 |

-0.465 |

7.5 |

0.414075 |

6.760 |

6.345521 |

-0.502 |

8.0 |

0.416915 |

7.156 |

6.739368 |

-0.535 |

8.5 |

0.419367 |

7.552 |

7.132896 |

-0.566 |

9.0 |

0.421497 |

7.947 |

7.525930 |

-0.592 |

9.5 |

0.423368 |

8.342 |

7.918742 |

-0.617 |

10.0 |

0.425026 |

8.736 |

8.311375 |

-0.638 |

10.5 |

0.428495 |

9.130 |

8.703660 |

-0.658 |

11.0 |

0.427812 |

9.524 |

9.095818 |

-0.676 |

11.5 |

0.429006 |

9.917 |

9.488068 |

-0.692 |

12.0 |

0.430073 |

10.310 |

9.879791 |

-0.708 |

12.5 |

0.431046 |

10.703 |

10.271504 |

-0.723 |

13.0 |

0.431947 |

11.096 |

10.663568 |

-0.733 |

13.5 |

0.432751 |

11.488 |

11.054852 |

-0.747 |

14.0 |

0.433501 |

11.880 |

11.446406 |

-0.758 |

14.5 |

0.434202 |

12.272 |

11.838192 |

-0.769 |

15.0 |

0.434827 |

12.664 |

12.229133 |

-0.781 |

15.5 |

0.435420 |

13.056 |

12.620502 |

-0.787 |

16.0 |

0.435971 |

13.448 |

13.011774 |

-0.796 |

16.5 |

0.436486 |

13.840 |

13.403097 |

-0.801 |

17.0 |

0.436978 |

14.232 |

13.794868 |

-0.814 |

17.5 |

0.437431 |

14.624 |

14.186113 |

-0.817 |

18.0 |

0.437830 |

15.014 |

14.576417 |

-0.824 |

18.5 |

0.438248 |

15.407 |

14.968422 |

-0.826 |

19.0 |

0.438598 |

15.797 |

15.358540 |

-0.842 |

19.5 |

0.438952 |

16.189 |

15.749647 |

-0.848 |

20.0 |

0.439309 |

16.581 |

16.141785 |

-0.850 |

20.5 |

0.439597 |

16.971 |

16.531586 |

-0.853 |

21.0 |

0.439899 |

17.363 |

16.922745 |

-0.859 |

21.5 |

0.440205 |

17.755 |

17.314880 |

-0.864 |

22.0 |

0.440480 |

18.146 |

17.705994 |

-0.872 |

22.5 |

0.440706 |

18.536 |

18.095703 |

-0.868 |

23.0 |

0.440940 |

18.927 |

18.486145 |

-0.875 |

23.5 |

0.441176 |

19.318 |

18.877213 |

-0.880 |

24.0 |

0.441437 |

19.711 |

19.270035 |

-0.884 |

24.5 |

0.441608 |

20.100 |

19.658813 |

-0.891 |

25.0 |

0.441817 |

20.492 |

20.049973 |

-0.886 |

25.5 |

0.442054 |

20.885 |

20.443130 |

-0.894 |

26.0 |

0.442232 |

21.276 |

20.833755 |

-0.993 |

26.5 |

0.442417 |

21.667 |

21.225006 |

-0.900 |

27.0 |

0.442540 |

22.056 |

21.613083 |

-0.900 |

27.5 |

0.442712 |

22.447 |

22.004257 |

-0.901 |

28.0 |

0.442854 |

22.837 |

22.394272 |

-0.909 |

28.5 |

0.443007 |

23.228 |

22.785156 |

-0.916 |

29.0 |

0.443213 |

23.623 |

23.179489 |

-0.917 |

29.5 |

0.443359 |

24.014 |

23.570724 |

-0.920 |

30.0 |

0.443496 |

24.405 |

23.961273 |

-0.921 |

30.5 |

0.443632 |

24.796 |

24.352417 |

-0.925 |

31.0 |

0.443694 |

25.183 |

24.739227 |

-0.925 |

31.5 |

0.443818 |

25.574 |

25.130219 |

-0.926 |

32.0 |

0.443942 |

25.965 |

25.521225 |

-0.929 |

32.5 |

0.444113 |

26.360 |

25.915939 |

-0.935 |

Parametry rozkładu dwuwykładniczego można oszacować z zależności:

(5.6)

gdzie: i Xm to parametry rozkładu; σn i

to odpowiednio populacyjne odchylenie standardowe i populacyjna średnia (wartości te podaje tabela 5.2.).

Tabela 5.2. Dane liczbowe do oszacowania parametrów rozkładu dwuwykładniczego wg [7]

n |

|

σn |

n |

|

σn |

8 |

0.484 |

0.904 |

49 |

0.548 |

1.159 |

9 |

0.490 |

0.929 |

50 |

0.549 |

1.161 |

10 |

0.495 |

0.950 |

51 |

0.549 |

1.162 |

11 |

0.500 |

0.968 |

52 |

0.549 |

1.164 |

12 |

0.503 |

0.983 |

53 |

0.550 |

1.165 |

13 |

0.507 |

0.997 |

54 |

0.550 |

1.167 |

14 |

0.510 |

1.010 |

55 |

0.550 |

1.168 |

15 |

0.513 |

1.021 |

56 |

0.551 |

1.170 |

16 |

0.516 |

1.032 |

57 |

0.551 |

1.171 |

17 |

0.518 |

1.041 |

58 |

0.551 |

1.172 |

18 |

0.520 |

1.049 |

59 |

0.552 |

1.173 |

19 |

0.522 |

1.057 |

60 |

0.552 |

1.175 |

20 |

0.524 |

1.063 |

62 |

0.553 |

1.177 |

21 |

0.525 |

1.070 |

64 |

0.553 |

1.179 |

22 |

0.527 |

1.075 |

66 |

0.554 |

1.181 |

23 |

0.528 |

1.081 |

68 |

0.554 |

1.183 |

24 |

0.529 |

1.086 |

70 |

0.555 |

1.185 |

25 |

0.531 |

1.091 |

72 |

0.555 |

1.187 |

26 |

0.532 |

1.096 |

74 |

0.556 |

1.189 |

27 |

0.533 |

1.100 |

76 |

0.556 |

1.191 |

28 |

0.534 |

1.105 |

78 |

0.556 |

1.192 |

29 |

0.535 |

1.109 |

80 |

0.557 |

1.194 |

30 |

0.536 |

1.112 |

82 |

0.557 |

1.195 |

31 |

0.537 |

1.116 |

84 |

0.558 |

1.197 |

32 |

0.538 |

1.119 |

86 |

0.558 |

1.198 |

33 |

0.539 |

1.123 |

88 |

0.558 |

1.199 |

34 |

0.540 |

1.125 |

90 |

0.559 |

1.201 |

35 |

0.540 |

1.128 |

92 |

0.559 |

1.202 |

36 |

0.541 |

1.131 |

94 |

0.559 |

1.203 |

37 |

0.542 |

1.134 |

96 |

0.560 |

1.204 |

38 |

0.542 |

1.136 |

98 |

0.560 |

1.206 |

39 |

0.543 |

1.139 |

100 |

0.560 |

1.206 |

40 |

0.544 |

1.141 |

150 |

0.565 |

1.225 |

41 |

0.544 |

1.144 |

200 |

0.567 |

1.236 |

42 |

0.545 |

1.146 |

250 |

0.569 |

1.243 |

43 |

0.545 |

1.148 |

300 |

0.570 |

1.248 |

44 |

0.546 |

1.150 |

400 |

0.571 |

1.254 |

45 |

0.546 |

1.152 |

500 |

0.572 |

1.259 |

46 |

0.547 |

1.154 |

750 |

0.574 |

1.265 |

47 |

0.547 |

1.156 |

1000 |

0.575 |

1.269 |

48 |

0.548 |

1.157 |

∞ |

0.577 |

1.283 |

5.1. Metoda graficzna

Każdy rozkład statystyczny zmiennej losowej X o dystrybuancie F(x) posiada sobie tylko właściwą siatkę funkcyjną o odciętej

(5.7a)

i rzędnej

(5.7b)

w której to siatce dystrybuanta F(x) jest linią prostą o równaniu

(5.8)

Współrzędne siatek funkcyjnych i równania prostych dla wybranych rozkładów statystycznych zestawiono w tabeli 5.3.

Tabela 5.3. Współrzędne liniowe wybranych rozkładów statystycznych

Rozkład/współrzędne |

η |

ζ |

Równanie prostej |

normalny |

|

x |

|

Weibulla dla siatki uniwersalnej |

|

ln(x-Xo) |

|

Weibulla dla siatki o ustalonym parametrze k |

|

x |

|

wykładniczy |

|

x |

|

dwuwykładniczy |

|

x |

|

równomierny |

F(x) |

x |

|

potęgowy |

lg[F(x)] |

lg(x) |

|

Wykorzystując współrzędne η i ζ, które po wykorzystaniu transformacji określonych wzorami z tabeli 5.3, są współrzędnymi liniowymi dla danego rozkładu, można zastosować metodę najmniejszych kwadratów dla określenia parametrów prostej (5.8):

(5.9a)

(5.9b)

gdzie za xi i yi podstawia się wartości obliczone z tabeli 5.3 przy podstawieniu za F(x) i x odpowiednich prawdopodobieństw z próby i wartości zmiennej losowej uzyskanych z badań. Oszacowane współczynniki

i

prostej pozwalają wykreślić dystrybuantę rozkładu w jego siatce funkcyjnej oraz wyznaczyć parametry rozkładu według wzorów podanych w tabeli 5.4.

Tabela 5.4. Określenie parametrów wybranych rozkładów na podstawie znajomości współczynników równania prostej w siatce funkcyjnej

Rozkład |

Parametry |

normalny |

|

Weibulla dla siatki uniwersalnej |

|

Weibulla dla siatki o ustalonym parametrze k |

|

wykładniczy |

|

dwuwykładniczy |

|

równomierny |

|

potęgowy |

|

Przykład 5.1.

Dane są wyniki badań zmiennej losowej jak w pierwszych trzech kolumnach tabelki 5.5. Dane te opracowano metodą graficzną dla trójparametrowego rozkładu Weibulla, który ma dwa rodzaje siatek funkcyjnych. Siatka uniwersalna wymaga uprzedniego określenia parametru przesunięcia Xo, a siatka o ustalonym parametrze kształtu k wymaga uprzedniego określenia tego parametru. W obydwu przypadkach dla określenia tych parametrów wykorzystano oszacowania punktowe (rozdz. 5.2.1) uzyskując odpowiednio

oraz

. Wykorzystując te dane - w oparciu o wzory z tabeli 5.3 - obliczono wartości

oraz

zestawione w kolumnach 4 i 5 dla siatki uniwersalnej i w kolumnach 6 i 7 dla siatki o ustalonym parametrze kształtu (tabela 5.5). Podstawiając te wartości do wzorów 5.9 oszacowano parametry

i

prostej 5.8. Znając parametry

i

- wykorzystując wzory z tabeli 5.4 - oszacowano poszukiwane parametry teoretycznego rozkładu Weibulla. Wyniki obliczeń zilustrowano rysunkami 5.1 i 5.2 odpowiednio dla siatki uniwersalnej i dla siatki o ustalonym parametrze kształtu. Jak widać w obu przypadkach uzyskano wyniki nieco różne, co jest w przypadku oszacowań statystycznych zrozumiałe i oczekiwane - oba sposoby wykorzystania metody graficznej dla rozkładu Weibulla wychodzą z odrębnych założeń. Raz zakłada się znajomość parametru przesunięcia a drugi raz zakłada się znajomość parametru kształtu.

Tabela 5.5. Dane do przykładu

Szereg kumulacyjny |

Siatka funkcyjna uniwersalna |

Siatka funkcyjna o ustalonym parametrze kształtu k |

||||

xi |

|

|

|

|

|

|

120 |

1 |

0.048 |

-3.020 |

3.437 |

0.433 |

120 |

125 |

2 |

0.095 |

-2.302 |

3.586 |

0.529 |

125 |

130 |

2 |